Auf dem Youtube Kanal VE99 erfahren ambitionierte Hobby Elektroniker, Techniker und Fachkräfte in Repair-Cafés, wie das alte Radio oder das Kassettendeck und vieles mehr repariert wird.

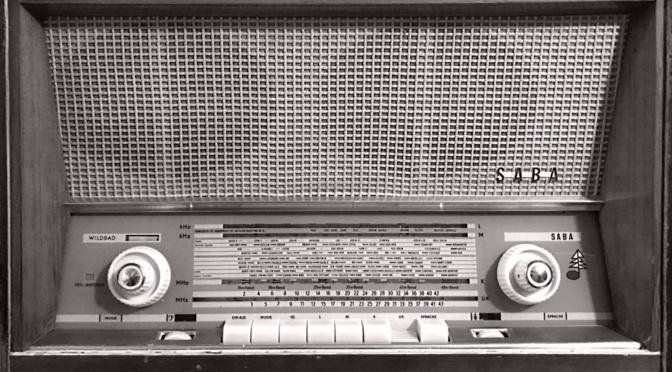

Das riesige Fachwissen von Jörg aus 5 Jahrzehnten Techniker in der Elektronik begeistert viele Hobby Elektroniker und erfährt grosse Beliebtheit bei Profis. Recherchen zeigen das der Kanal am 10.07.2022 mehr als 11.000 Abonnenten verzeichnete, heute nach über 3 Jahren am 26.12.2025, zeigt der Status bereits 25.300 Abonnenten und 390 Videos. VE99 hilft auf einfache aber eindrückliche Weise bei der Reparatur von defekten Audio-Verstärkern oder alten Röhrenradios und vieles mehr, erklärt Schaltnetzteile und zeigt bei der Reparatur eindrücklich die Fehlersuche, anhand des Schaltplanes wird erklärt wie vorzugehen ist.

Die Videos sind einfach und direkt gehalten, ohne überflüssige Intros und ohne Spezialeffekte wird auf Inhalt gesetzt. Der Kanal vermittelt reines Fachwissen in der Tiefe, die Kamera in der Werkstatt zeigt gestochen scharf das Innere, die ausgebaute Platine mit den Bezugspunkten zur Messung, die Bauelemente und oft mit einem schwenk die Sicht zum Messgerät und zum Schaltplan. In ruhiger Art erklärt Jörg das gemessene Signal auf dem Analyzer oder dem Oszilloskop. Das Ziel soll sein, die Nachhaltigkeit zu fördern.

Die Reparatur defekter Elektronik Geräte und Schaltungen betreffen oft nur einzelne Bauteile, die Kosten der Bauteile sind oft unbedeutend klein, das Problem ist mehr, das nicht mehr funktionierende Elektronik Geräte heute fortgeworfen werden, da die Arbeitsstunden zu hoch sind und das Fachwissen immer weniger wird.

Mit VE99 leistet Jürg Haase ein riesiges Vermächtnis an Fachwissen, in vielen Stunden beharrlicher Instandsetzung von noch so aussichtslos erscheinenden Reparaturen, zeigt er auf verständliche Art und Weise wie es geht, öfters mit einem Hauch von Ironie wird auf einen Missstand hingewiesen, oder falsche und irreführende Aussagen die ihren Ursprung bei fragwürdigen Fachwerkstätten oder Anbieter haben, werden anhand von Messungen und fakten direkt widerlegt.